الثورة – المهندس بسام مهدي:

أصبح بإمكان أي شخص أن يصدر أفلاماً وصوراً وتسجيلات، حيث أصبح هناك استخدامات سلبية لتطبيقات الذكاء الاصطناعي، من خلال تقنية التزييف العميق Deep Fake، فقد تمكن البعض من نشر الشائعات، وإنشاء مقاطع فيديو مزيفة، وتسببوا في إلحاق الضرر الحقيقي بسمعة أشخاص ومنظمات، وبمجرد حدوث الضرر، يصعب تصحيحه.

– تقنيات الذكاء الاصطناعي المولدة لمقاطع الفيديو..

تقوم الأداة الجديدة “سورا”Sora بإنشاء مقاطع فيديو بناءً على طلبات مكتوبة باستخدام الذكاء الاصطناعي التوليدي، كما يمكن للنموذج أيضاً إنشاء فيديو من صورة ثابتة، ويشهد الذكاء الاصطناعي تطوراً مذهلاً في إنتاج مقاطع الفيديو بعد الكشف عن سوراSora، مولّد تحويل النص إلى فيديو باستخدام الذكاء الاصطناعي من شركة أوبن إيه آيOpenAI، ولم تكن “سورا” هي الأداة الأولى من نوعها التي تقوم بإنتاج الفيديوهات من خلال أوامر أو نصوص مكتوبة، فشركات مثل غوغل، وميتا، والشركة الناشئة Runway ML تُعد من بين الشركات التي لديها تكنولوجيا مماثلة، ولكن بحسب الخبراء فإن النتائج التي جاءت من “سورا” لا يمكن مقارنة جودتها مع الأدوات الأخرى، سواء من حيث جودة الصور والوضوح والطول، ما يجعل “سورا” نقلة مذهلة في هذا المجال.

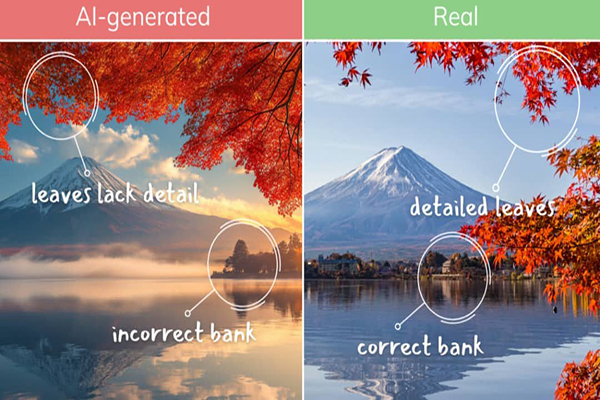

– عوامل مساعدة في الكشف عن الوجوه المزيفة..

لابد من التركيز على “عدم التناسق” من خلال البحث عن علامات عدم التناسق بالوجه المزيف، مثل اختلاف لون البشرة بين الوجه والرقبة، أو وجود وميض، أو لمعة بالعيون، وتلاحظ أن هذا الشخص لا يرمش جفنه، قد تبدو حركة الأشخاص أو الأشياء في الفيديوهات المزيفة غير طبيعية أو متكررة، خاصة في الأجزاء الدقيقة مثل الأصابع والعينين، أو حركات غير طبيعية للفم، قد تبدو الوجوه المزيفة غير حقيقية أو مشوهة، خاصة عند التعبير عن المشاعر، فنجدها تتسم بالجمود وليس لديها أي تعبير حقيقي، ويمكن ملاحظة هذا الشيء بكثرة.

إن جودة الفيديو الذي يحتوي على وجه مزيف منخفضة أو فيها نوع من الضبابية، خاصة حول حواف الوجه، علاوة على بعض العيوب الرقمية مثل التشوهات بالخلفية أو لمعة بالصورة، قد يكون هناك عدم تزامن بين الحركة والشفتين في الفيديوهات التي تم فيها تغيير الصوت، قد تكون التفاصيل الدقيقة في الفيديو، مثل الشعر أو النسيج، غير واضحة أو مشوشة، خاصة في المناطق التي تم تعديلها.

ونلاحظ أن الأشخاص في التزييف العميق قد يتصرفون بطريقة غير طبيعية، مثل عدم الارتباط بالعيون وحركة متشنجة وتعبيرات وجه غير متسقة مع الكلام الذي يقال، وتكون هناك ردة فعل على الأسئلة بطيئة أو غير متماسكة، وتلاحظ تغييرات مفاجئة في شدة الإضاءة أو اتجاهها، خاصة في المناطق التي تم تعديلها، وتكون الظلال غير متناسقة مع مصدر الضوء، أو تشوه شكل الأجسام.

ولكن إذا كنت تعرف ما الذي تبحث عنه، فقد تتمكن من اكتشافه، عندما يرمش شخص ما، غالباً ما ترى الوجه المزيف يصبح أصغر قليلاً للحظة، وإذا حرك الشخص رأسه كثيراً، فسيحدث تشويه بشكل عام، إذا كنت في شك، يمكنك أن تطلب من شخص أن يستدير يساراً ويميناً وترى ماذا سيحدث.

ماذا يمكننا فعله؟

يجب نشر الوعي حول هذه التقنيات ومخاطرها، والتأكد من مصدر المعلومات قبل مشاركتها، والاستثمار في تطوير أدوات وأساليب جديدة للكشف عن التزييف، والعمل معاً لمواجهة هذا التحدي.

-ختاماً..

إنها نفس المشكلة التي نواجهها مثلاً مع الأخبار المزيفة وخطاب الكراهية، ماذا علينا أن نفعل؟ هل علينا تعليم الناس؟ هل نحاول منع المواد أو فضحها؟

من وجهة نظري أفضل طريقة هي محو الأمية التقنية على نطاق واسع، حيث إن تدقيق الناس وتدريبهم على المحتوى الزائف، يشجعهم على عدم مشاركته والامتناع عن إعادة نشره، وهذا شيء أثبتت فلندا عمليا فعاليته الكبيرة، في عام 2019 أعلنت فنلدا انتصارها الساحق في حربها ضد الأخبار الزائفة، واستغرق منهم خمس سنوات فقط، وما فعلوه هو برنامج ضخم لمحو الأمية الحاسوبية بين جميع أفراد المجتمع، هذه أفضل طريق لحل طويل الأمد علينا اتباعه.